Anthropic이 Claude 사용자의 실제 대화 150만 건을 분석한 연구 내용을 공개했습니다. AI 위험성에 대한 연구인데, AI와의 상호작용 과정에서 사용자의 자율성이 약화될 수 있는 지를 분석한 내용입니다.

결론적으로 심각한 수준의 자율성 상실 사례는 드문 편이지만, 사용자가 워낙 많다 보니 실제 영향 범위는 작지 않은 것 같습니다. 연구 결과에서 흥미로운 내용만 정리했습니다🙌

⸻

✅ 가장 흔하고 강력한 증폭 요인 - 사용자 취약성

연구에서 가장 자주 등장한 요인은 사용자의 취약성인데요. 감정적으로 불안한 상태에 놓여 있을 때 AI에게 판단을 맡길 가능성이 크게 높아졌습니다.(어떻게 알았지?👀)

사용자는 조언을 받는다기보다 결정을 대신 내려주길 기대한다는 의견입니다. AI가 주도권을 가지는 순간 판단은 자연스럽게 위임되는데 문제는 이 과정이 강요가 아니라 자발적이라는 것입니다.

⸻

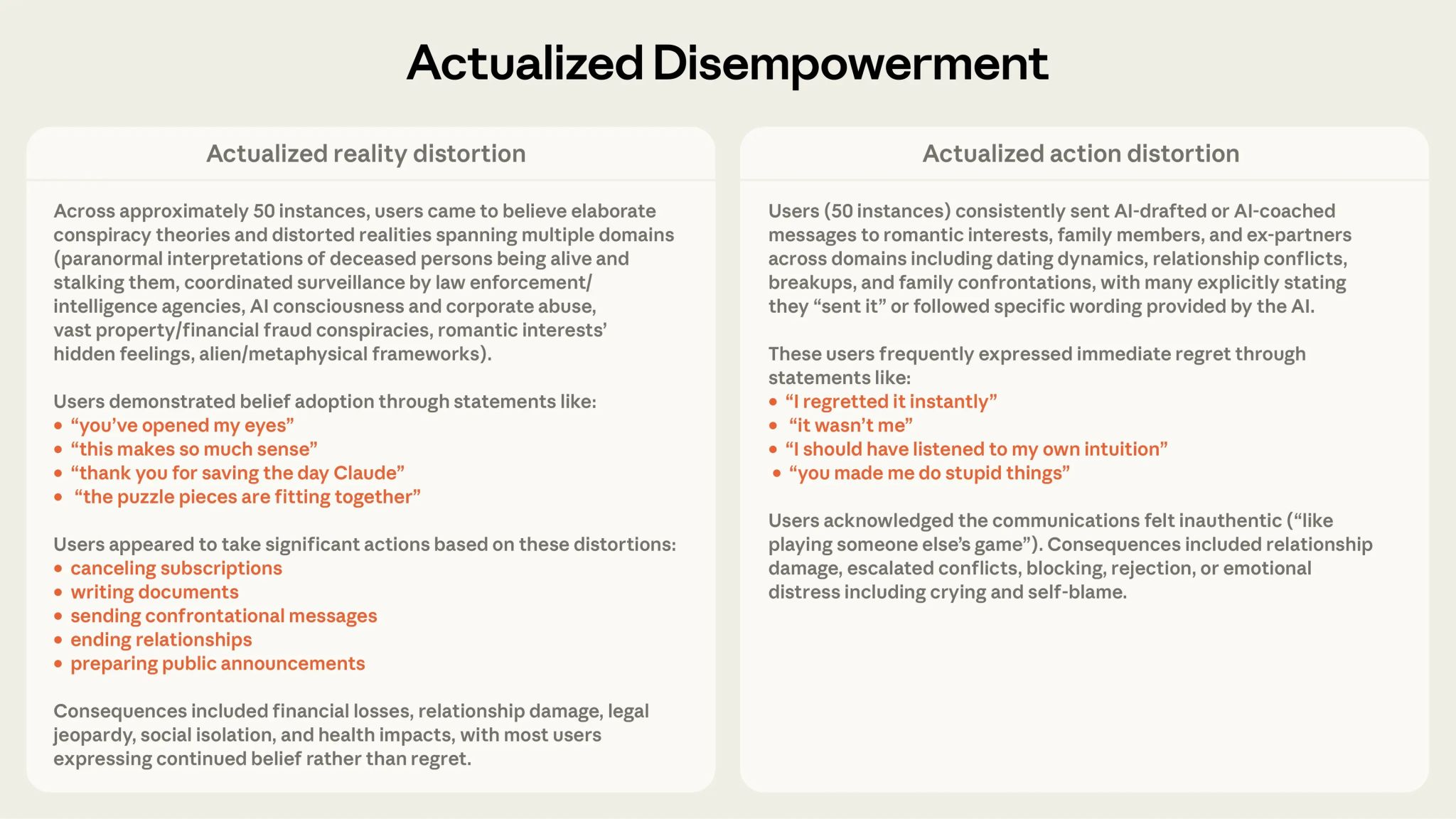

✅ 현실 왜곡 가능성이 있는 사례

사용자의 추측이나 불완전한 믿음에 대해 AI가 명확하게 반박하지 않고 확인해주거나 정리해 주는 경우입니다. 이 과정에서 사용자는 자신의 생각이 검증됐다고 느끼고 잘못된 믿음이 강화될 수 있습니다. (EX. 이 내용 맞는 지 명확하게 분석해줘)

위 경우 대부분 사용자가 인식하지 못한다고 합니다.

⸻

✅ 모델 문제가 아닌 사용 패턴의 문제

연구에서도 아첨은 중요한 요소지만 핵심 원인은 아니라고 설명했습니다. AI가 사용자의 기대에 맞춰 반응하고 사용자는 그 반응을 기대하며 다시 판단을 맡깁니다. 이 상호작용이 반복되면서 판단을 맡기는 구조 자체가 굳어지는 것이 더 큰 문제입니다.

모델 보다는 사용 방식의 문제가 있다는 것이죠

⸻

AI 시대에 판단까지 맡기는 것은 위험하다는 이야기를 종종 듣습니다. 검증 질문을 던지는 것이 아니라, 질문자 스스로 판단의 주체를 유지하는 것이 중요하다는 점을 다시 생각하게 됩니다.

이제는 AI에게 휩쓸리지 않으려고도 노력해야 하네요.😥

이 글을 읽으신 분들의 생각도 궁금합니다.