지난 시간에 딥리서치를 활용해 방대한 외부 자료를 수집하는 법을 알아봤습니다. 하지만 여기에서 끝난 것이 아니죠. 수집한 자료가 아무리 많아도 핵심을 파악하지 못하거나, 내가 가지고 있는 자료들을 함께 활용하지 못한다면 이중작업이 발생하게 됩니다.

딥리서치로 생성한 'MZ 세대 퇴사율' 자료를 본 안 대리가 입을 열었습니다.

맞아요, 최프로님. 딥리서치로 순식간에 수십 페이지를 만들어 주니 놀랍기는 한데,

이걸 또 언제 읽어 보나 싶더라고요. 게다가 기존 자료와 중복되는 내용이 있는 건지도 모르겠고,

하나의 맥락에서 파악할 수 있으면 좋겠어요.

저는 이번 세션의 주제에 대해 슬라이드를 띄웠습니다.

결국 우리가 이렇게 수집한 자료들을 제대로 활용하기 위해서는

먼저 외부 정보 외에 내부 정보를 함께 활용할 수 있어야 하고,

또 이 정보들을 한꺼번에 활용해서 인사이트를 찾아낼 수 있도록 해야겠죠.

이 두 가지를 해결해 줄 수 있는 도구가 바로 노트북LM입니다.

일반 LLM 서비스의 한계 극복하기

그럼, 노트북LM의 활용법에 대해 본격적으로 알아보기 전에, 왜 이런 툴이 필요한지, 노트북LM은 무엇이 다른지 먼저 짚어볼 필요가 있을 것 같습니다. AI 도구의 경우 워낙 기능 추가나 변경이 많다 보니, 어떻게 쓰는지 보다 목적과 구동 원리를 제대로 이해해야 다양하게 활용할 수 있죠.

노트북LM이 필요한 이유는 명확합니다. 바로 챗GPT나 제미나이 같은 범용 서비스들의 한계 때문입니다. 이런 서비스들은 인터넷에 있는 방대한 정보를 학습했기에 모든 것을 아는 것처럼 보이지만, 우리가 가진 내부 자료나 검색이 되지 않는 정보에 대해서는 알 수가 없죠.

따라서 막상 우리 업무에 필요한 전문 분야에 대해 질문을 하면, 우리에겐 너무나 당연한 사실을 이 똑똑한 AI가 모르는 현상이 발생하는데요. 더구나 AI는 학습된 일반 지식을 바탕으로 그럴듯한 답변을 만들어내기 때문에 환각(할루시네이션)까지 발생할 가능성이 있습니다. 우리가 AI를 업무에 사용하기 주저하게 되는 핵심적인 요인 중 하나죠. 이런 한계를 극복하기 위해 등장한 기술이 바로 RAG(검색 증강 생성)인데요.

RAG는 실시간으로 변하는 외부 데이터베이스나 내부 시스템과 AI를 직접 '연동'하는 훨씬 광범위하고 강력한 개념입니다. 예를 들어 최신 의료 논문 데이터 베이스를 연결한다던가, 우리 회사의 내부 DB와 연결하는 방식을 생각해 볼 수 있죠.

가까운 예로, 챗GPT와 연동되어 있는 Scholar GPT를 생각해 볼 수 있습니다. 챗GPT의 일반적인 기능에 2억 개 이상의 논문 DB가 연결되어 있는 맞춤형 GPT입니다. 일반 챗GPT와의 대화에서는 얻을 수 없는 논문을 찾을 수 있고, AI 기능을 활용해 해당 논문을 요약하거나 재가공하는 것도 가능하게 됩니다.

만약 RAG를 활용해 우리 회사에 필요한 여러 정보들과 회사 시스템까지 연동해서 제공한다면 AI의 쓸모는 훨씬 올라갈 겁니다. 하지만 이런 자체 시스템을 구축하려면 상당한 전문성과 자원이 필요한 일이라 현실적으로 일반 기업들이 도입하기는 (아직) 쉽지 않죠.

이런 이유로 노트북LM은 훌륭한 대안이 될 수 있습니다. 복잡한 시스템적인 연결 대신, 사용자가 가진 '문서'를 중심으로 일반 AI의 단점을 극복하고, RAG 장점을 쉽게 활용할 수 있도록 하는 서비스죠. 핵심은 '소스 그라운딩(Source-Grounded)' 방식에 있습니다. 뭔가 복잡하고 어려워 보이지만 간단합니다.

따라서 노트북LM은 AI의 고질적인 문제인 환각(Hallucination) 현상의 발생을 차단할 수 있습니다. 또 노트북LM의 모든 답변에는 원본 문서의 어느 부분에 근거했는지 인용 표시를 해주기 때문에, 사용자가 즉시 원문을 검증할 수 있게 되죠. 개발 지식이 없어도, 우리는 클릭 몇 번만으로 내가 제공한 문서에 기반해 답변하는 똑똑한 AI를 고용할 수 있게 된 거죠.

나만의 정보 분석팀, 제대로 활용하기

원리나 기술적인 부분에 대한 설명은 이쯤 하고, 앞서 이야기했던 'MZ세대 퇴사율' 보고서 작성을 위해 노트북LM으로 자료를 파악하고 분석하는 과정을 직접 살펴보죠.

참고로, 아래 내용은 'MZ 세대 퇴사에 원친과 대책 보고서 (딥리서치)' '가우스 F&B의 퇴사자 심층 인터뷰' '가우스 생명의 Young Talent 이탈 원인 분석' '천리마 식품 MZ 세대 유지를 위한 리텐션 전략' 등의 자료를 분석한 결과입니다. (물론 모두 가상의 회사이지만 실제 보고서를 만들어 분석을 진행했습니다)

1단계. 나만의 AI 지식베이스 구축하기

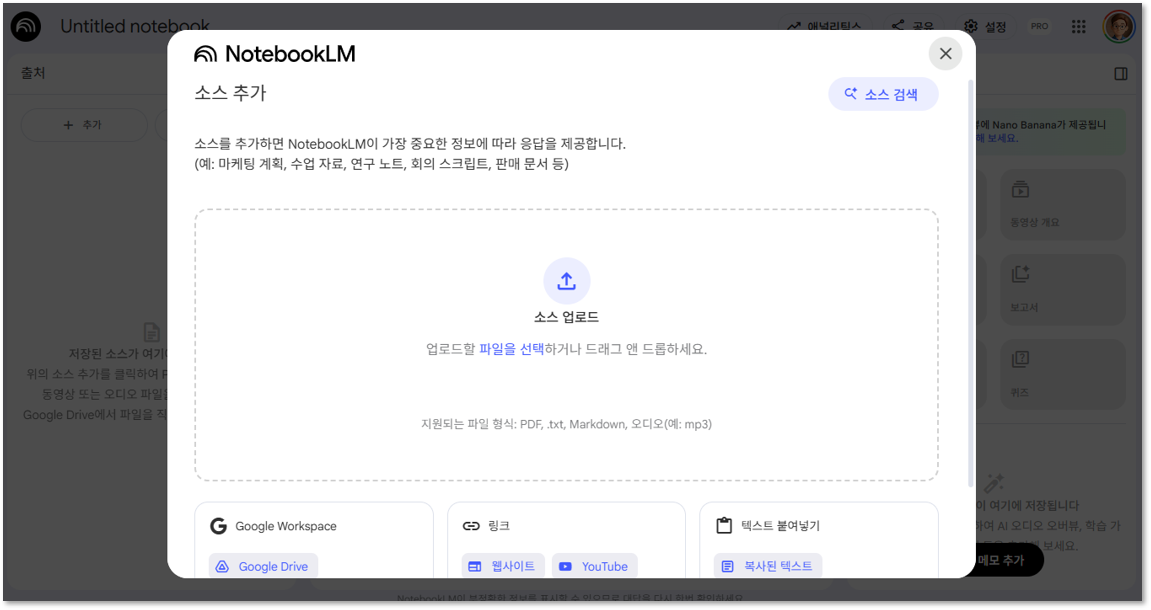

노트북LM에 접속해 새 '노트북'을 만들고, 이곳에 안 대리의 'MZ세대 리서치' 관련 자료를 모두 업로드합니다. 지난 세션에 만들었던 딥리서치로 수집한 자료나 관련 웹사이트(URL)는 물론, 다른 F&B 업계 인사팀 친구를 통해 구한 자료나 계열사를 통해 확보한 자료까지 한꺼번에 넣습니다.

노트북LM의 소스 등록 화면. 다양한 형태의 파일 등록이 가능합니다.

노트북LM에는 위의 화면과 같이 유튜브 링크나 구글 드라이브 자료도 바로 등록이 가능하며, 무료 버전에서는 100개의 노트를 만들고 노트 하나당 최대 50개의 소스를 등록할 수 있습니다, (유료 버전은 500개 노트와 300개 소스)

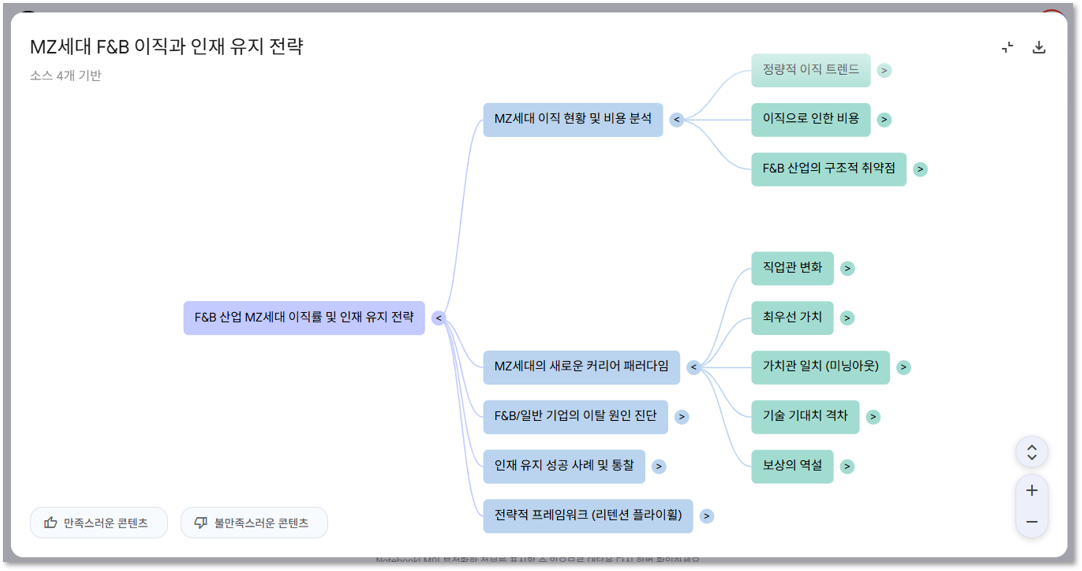

2단계. 마인드맵을 활용해 전체 그림 조망하기

소사를 다 추가했다면, 바로 세부 내용을 파고드는 것보다 전체 구조를 먼저 파악하는 것이 효율적입니다. 이때 '마인드맵' 기능을 활용하면, 수십 개 문서의 핵심 주제와 하위 개념이 시각적으로 자동 구조화되어 전체 내용의 뼈대를 빠르게 파악할 수 있습니다.

마인드맵을 선택하면 전체 파일들의 구조를 트리화해서 보여줍니다.

3단계. 질문으로 핵심 내용 파악하기

전체 구조를 파악했다면 이제 구체적인 질문을 할 수 있습니다. "업로드된 모든 자료를 기반으로, MZ세대 퇴사율의 5가지 핵심 원인을 요약해 줘"와 같이 입력한다면 몇 초 후, 노트북LM은 우리가 올린 문서를 토대로 종합된 답변을 출처와 함께 제시합니다.

그리고 범용 AI는 절대 할 수 없는, '내부'와 '외부' 자료를 연결하는 질문을 던질 수 있겠죠. "가우스 F&B 퇴사자 심층 인터뷰' 자료와 타사 및 리포트 자료를 비교해서, 우리 회사만 겪는 특이한 퇴사 사유가 있다면 알려줘"라고 요청했습니다.

노트북LM이 분석한 내용은 아래와 같습니다.

제공해 주신 자료들('가우스 F&B 퇴사자 심층 인터뷰'와 타사/일반 리포트)을 비교 분석한 결과, 가우스 F&B만이 겪는 독특하거나 유난히 두드러지는 퇴사 사유는 "강력한 브랜드 이미지와 달리, 실무자가 아이디어의 주인이 될 수 없는 창의적 주도권의 부재"로 요약할 수 있습니다.

4단계. 분석 결과를 원하는 포맷으로 재가공하기

노트북LM은 '스튜디오(Studio)' 패널을 활용해 분석한 내용을 다양한 포맷으로 자동 생성할 수 있는 기능을 강화하고 있습니다. 예를 들어, 리서치 핵심 내용을 요약하는 짧은 '비디오 오버뷰'를 만들거나, AI 호스트 두 명이 대화하는 형식의 '오디오 오버뷰'를 생성할 수도 있죠. 클릭 한 번으로 보고서 초안이나 FAQ 리스트를 만들 수도 있습니다.

최근에는 비디오 오버뷰 등을 만들 때 단순히 브리핑을 해주는 방식을 넘어 어떤 관점에서 오버뷰를 생성할지를 요청할 수 있도록 하고 있는데요. 아래 내용은 가우스 F&B의 관점에서 전반적인 트렌드 및 타사와 비교해 달라고 요청한 비디오 오버뷰입니다.

이해를 넘어 전략 수립의 단계로...

비디오 오버뷰까지 보고 난 안대리가 입을 열었습니다.

음.. 마인드맵이나 비디오로 보니 확실히 전체 내용이 한눈에 들어오네요. 어떤 관점에서 접근해야 할지 바로 감이 잡힙니다. 다만... 분석한 퇴사 이유가 생각보다 복합적이어서 이 부분을 어떻게 정리해야 할지 고민이 되는데요.

그럼, 우리는 이 분석 내용을 토대 바로 보고서 작성을 시작할 수 있을까요?

이제 분석을 통해 '무엇을 말할지(방향성)'가 명확해졌으니, 다음은 '어떻게 말할지', 즉 보고서의 목적에 맞게 탄탄한 구조(뼈대)를 설계하는 단계입니다. 그리고 이 과정 역시 AI의 도움을 받을 수 있죠. AI를 활용해 가장 설득력 있는 구조를 먼저 설계하고, 그 뼈대에 맞춰 논리적인 초안을 만들어내게 됩니다.

다음 시간에는 우리가 잡은 방향성을 토대로, AI와 함께 보고서 초안을 완성하는 '공동 집필'의 세계로 넘어가 보도록 하겠습니다.

<< 다음 글로 이어집니다 >>